Contraste de hipótesis.

Se revisan los pasos del contraste de hipótesis: hipótesis nula y alternativa, elección del estadístico, cálculo del valor de p y decisión.

A diario nos enfrentamos a multitud de situaciones en las que siempre actuamos de la misma manera. Decimos que vamos a sota, caballo y rey. Y esto es bueno, porque se supone que este tipo de actuaciones nos salen de forma rutinaria, sin tener que pensar en ellas.

El problema es que para hacer una cosa a sota, caballo y rey tenemos que comprender bien cómo hacerla. De lo contrario podemos hacer cualquier cosa menos lo que pretendemos.

Contraste de hipótesis

Un ejemplo es el contraste de hipótesis. Siempre es lo mismo: sota, caballo y rey. Y, sin embargo, al principio nos parece algo más complicado de lo que realmente es. Porque, con independencia del contraste que estemos haciendo, los pasos a seguir son siempre los mismos: establecer nuestra hipótesis nula, seleccionar el estadístico adecuado para cada situación, utilizar las distribución de probabilidad correspondiente para calcular la probabilidad de ese valor del estadístico que hemos empleado y, según este valor de probabilidad, decidirnos en favor de la hipótesis nula o de la alternativa. Vamos a analizar estos pasos uno a uno y utilizando un ejemplo concreto para comprenderlos mejor.

La hipótesis nula

Lo primero, establezcamos la hipótesis nula y la alternativa. Como ya sabemos, cuando hacemos un contraste de hipótesis podemos rechazar la hipótesis nula si el estadístico del contraste tiene una determinada probabilidad. Lo que no podemos hacer nunca es aceptarla, solo rechazarla. Por eso se plantea habitualmente la hipótesis nula como lo contrario a lo que queremos demostrar, para poder rechazar lo que no queremos demostrar y aceptar lo que sí queremos demostrar.

En nuestro caso vamos a plantear la hipótesis nula de que la talla de nuestros alumnos es igual a la de la media de la provincia y que la diferencia encontrada es debida al error de muestreo, al puro azar. Por otra parte, la hipótesis alternativa plantea que sí existe una diferencia y que nuestros niños son más bajos.

Elección del estadístico

Una vez planteadas la hipótesis nula y alternativa tenemos que elegir el estadístico adecuado para este contraste de hipótesis. Este caso es uno de los más sencillos, el de comparación de dos medias, la nuestra y la de la población. En este caso, nuestra media estandarizada respecto a la de la población sigue una distribución t de Student, según la siguiente fórmula que me vais a permitir:

t = (media del grupo – media de población) / error estándar de la media

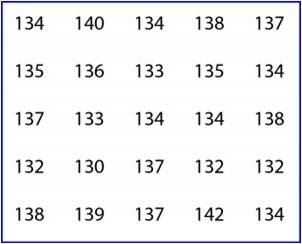

Así que sustituimos la media por nuestro valor (135,4 cm), la media poblacional por 138 y el error estándar por su valor (la desviación estándar dividida por la raíz cuadrada del tamaño muestral) y obtenemos un valor de t de -4,55.

El valor de p

Ahora tenemos que calcular la probabilidad de que t sea igual a -4,55. Si pensamos un poco veremos que en el caso de que las dos medias fuesen iguales t tendría un valor de cero. Cuánto más distintas sean, más se alejará el valor de t del cero. Nosotros queremos saber si esta desviación, de cero a -4,55, se debe al azar. Para ello calculamos la probabilidad de que t valga -4,55 utilizando una tabla de la distribución de la t de Student o un programa informático, obteniendo un valor de p = 0,0001.

El contraste

Ya tenemos el valor de p, así que solo nos queda el último paso, ver si podemos rechazar la hipótesis nula. El valor de p nos indica la probabilidad de que la diferencia observada entre las dos medias se deba al azar. Como es menor de 0,05 (menor del 5%), nos sentimos lo suficientemente seguros como para decir que no es debida al azar (o, al menos, es muy improbable), así que rechazamos la hipótesis nula de que la diferencia se debe al azar y abrazamos la hipótesis alternativa de que las dos medias son realmente diferentes. Conclusión: nos ha tocado la clase de los más canijos de la provincia.

Y esto es todo respecto al contraste de hipótesis de igualdad de dos medias. En este caso hemos hecho una prueba de la t de Student para una muestra, pero lo importante es que os fijéis en la dinámica del contraste de hipótesis. Siempre es la misma: sota, caballo y rey. Lo que cambia, lógicamente, es el estadístico y la distribución de probabilidad que usamos en cada ocasión.

Nos vamos…

Para terminar solo me queda llamar vuestra atención sobre otro método que podríamos haber utilizado para saber si las muestra son diferentes. Este no es más que recurrir a nuestros queridos intervalos de confianza. Podríamos haber calculado el intervalo de confianza de nuestra media y ver si incluía la media de la población, en cuyo caso habríamos concluido que eran similares. Si la media poblacional hubiese estado fuera del intervalo, habríamos rechazado la hipótesis nula, llegando lógicamente a la misma conclusión. Pero esa es otra historia…