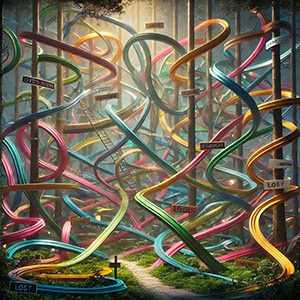

Demasiados caminos, ningún destino

Contrario a lo que podría pensarse, la inclusión de un número elevado de variables en un modelo de regresión lineal puede ser contraproducente para su rendimiento, produciendo un sobreajuste de los datos y disminuyendo la capacidad de generalización. Es la conocida como maldición de la multidimensionalidad.