El coeficiente kappa de concordancia interobservador.

Cuando tenemos medidas obtenidas por dos observadores, el coeficiente kappa permite separar el grado de coincidencia debido al azar.

Todos sabemos que a cuantos menos médicos vayamos, mucho mejor. Y esto por dos razones. La primera, porque si vamos a muchos médicos o estamos muy malos físicamente o estamos muy malos de la cabeza (algunos desgraciados de las dos cosas). Y la segunda, que es la que más me llama la atención, porque cada uno te dice una cosa diferente. Y no es que los médicos no conozcamos el oficio, es que ponerse de acuerdo no es tan sencillo como parece.

Para que os hagáis una idea, el problema empieza ya al querer saber si dos médicos que valoran una misma prueba diagnóstica tienen un buen grado de acuerdo. Veámoslo con un ejemplo.

El problema del gerente

Supongamos por un momento que soy el gerente del hospital y quiero contratar un patólogo porque el único que tengo está desbordado de trabajo.

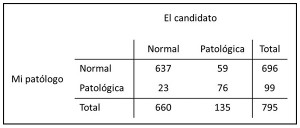

Nos preguntamos qué grado de acuerdo o, mejor dicho, concordancia hay entre los dos. Lo primero que se nos ocurre es ver en cuántas biopsias están de acuerdo y lo calculamos: los dos coinciden en 637 biopsias normales y en 76 en las que ven células malignas, luego el porcentaje de casos en los que están de acuerdo puede calcularse como (637+76)/795 = 0,896. ¡Albricias!, nos decimos, los dos están de acuerdo en casi el 90% de los casos. La cosa no es tan mala como parecía viendo las discrepancias de la tabla.

Pero resulta que cuando estoy a punto de contratar al nuevo patólogo me pregunto si no podría haber acertado por pura casualidad.

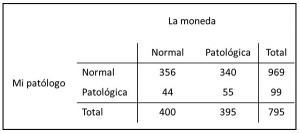

La moneda me dice que tengo 400 biopsias normales y 395 con células malignas. Si calculo la concordancia entre la moneda y el patólogo, veo que es de (356+55)/795 = 0,516, ¡52%!. Esto sí que es sorprendente, por puro azar están de acuerdo en la mitad de los casos (sí, sí, ya sé que los más listillos no se sorprenderán y me dirán que hay un 50% de cada resultado de lanzar la moneda). Así que empiezo a pensar formas de ahorrar dinero para mi hospital y se me ocurre otro experimento que esta vez no es solo estúpido, sino totalmente ridículo: le ofrezco a mi primo que haga la prueba en lugar de lanzar la moneda (por esta vez voy a dejar tranquilo a mi cuñado).

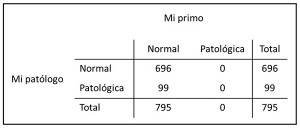

El problema, claro está, es que mi primo no es médico y, aunque es un tío majo, de anatomía patológica no tiene ni idea. Así que cuando empieza a ver las células de colores piensa que es imposible que semejante belleza esté producida por células malignas y da todos los resultados como normales. Cuando vemos la tabla con los resultados lo primero que se me ocurre es quemarla, pero por pura curiosidad calculo la concordancia entre mi primo y mi patólogo y veo que es de 696/795 = 0,875, ¡¡87%!!. Conclusión: igual me trae más cuenta contratar a mi primo que a un nuevo patólogo.

El concepto de concordancia

A estas alturas pensaréis que hoy se me ha olvidado tomar la medicación, pero la verdad es que todos estos ejemplos sirven para demostraros que, si queremos saber cuál es la concordancia entre dos observadores, primero tenemos que desembarazarnos del efecto del engorroso y sempiterno azar. Y para eso los matemáticos han inventado un estadístico que llaman kappa, el coeficiente de concordancia interobservador.

Kappa lo que hace es excluir de la concordancia observada aquella que es debida al azar, obteniendo un valor más representativo de la fuerza de la concordancia entre los observadores. Su fórmula es un cociente en cuyo numerador se representa la diferencia entre la concordancia observada y la debida al azar y en cuyo denominador figura el complementario de la concordancia debida al azar: (Po-Pa)/(1-Pa).

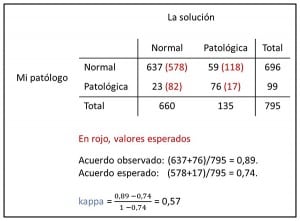

La Po de nuestro ejemplo con los dos patólogos ya la conocemos: 0,89. Para calcular la Pa debemos calcular los valores teóricos esperados de cada celda de la tabla, de forma similar a como recordaréis de la prueba de la chi cuadrado: el valor esperado de cada celda es el producto de los totales de su fila y columna dividido por el total de la tabla. Como ejemplo, en nuestra tabla el valor esperado de la primera celda es (696×660)/795 = 578. Con los valores esperados calculamos la probabilidad de acuerdo debido al azar empleando el mismo método que usamos antes para la observada: (578+17)/795 = 0,74.

Coeficiente kappa

Y ahora ya podemos calcular kappa = (0,89-0,74)/(1-0,74) = 0,57. ¿y qué hacemos con el 0,57?. Podemos hacer lo que se nos ocurra, menos multiplicarla por cien, ya que este valor no representa un verdadero porcentaje. Kappa puede valer de -1 a +1. Valores negativos indican que la con

Un valor de 0 indica que la concordancia es similar a la que se obtendría tirando una moneda. Valores mayores de 0 indican que hay concordancia leve (0,01-0,20), aceptable (0,21-0,40), moderada (0,41-0,60), considerable (0,61-0,80) o casi perfecta (0,81-1,00). En nuestro caso, hay una concordancia bastante buena entre los dos patólogos. Si tenéis curiosidad, calculad la kappa de mi primo y veréis que no es mejor que tirar la moneda.

Kappa puede calcularse también si tenemos medidas de varios observadores o varios resultados de una observación, solo que las tablas se ponen tan antipáticas que es mejor utilizar un programa estadístico para calcularla que, ya de paso, nos puede dar su intervalo de confianza.

De todas formas, no confiéis mucho en la kappa, ya que requiere que no haya mucha diferencia entre las celdas de la tabla. Si alguna de las categorías tiene pocos casos el coeficiente tenderá a subestimar la concordancia real aunque ésta sea muy buena.

Nos vamos…

Por último, deciros que, aunque en todos nuestros ejemplos hemos visto una prueba con un resultado dicotómico, es posible también calcular la concordancia entre observadores que nos den un resultado cuantitativo (una escala de puntuación, por ejemplo). Claro que para eso tenemos que utilizar otra técnica estadística como la de Bland-Altman, pero esa es otra historia…

Entrada sobre tema complejo, a la que hay que agradecer la introducción al parámetro y la explicación de su interés. La idea de fondo es la incertidumbre sobre el proceso de medición. Si bien en medicina se hace más hincapié en la incertidumbre sobre la toma de decisiones (¿está enfermo? ¿tengo que poner este tratamiento? ¿va a funcionar este tratamiento?), no hay que olvidar que esta limitación procede de los distintos pasos (¿escucho el mismo soplo que mi compañero? ¿esta imagen de la radiografía es una neumonía?) que se van dando.

En cuanto al oceficiente kappa como tal, para los que queráis profundizar, o más bien conocer sus límites, os paso lo que fácilmente podéis googlear (la supuesta sabiduría de uno se resentiría sin san google):

«1. El valor de kappa se ve afectado por la prevalencia del rasgo estudiado. Por tanto, es necesario ser cuidadoso a la hora de generalizar los resultados de comparación de observadores en situaciones con prevalencias diferentes; esto quiere decir que kappa es un estadístico descriptivo útil, pero es inadecuado con fines de predicción o inferencia

=>Es decir, cuando lo que se quiere discriminar es muy frecuente o muy poco frecuente, es muy fácil coincidir por azar entre los observadores. Como el kappa no tiene en consideración este aspecto, puede salir muy bajo e indicar baja concordancia cuando en realidad no tiene por qué ser así.

2. Kappa es dependiente del número de categorías. Cuantas más categorías se estén considerando, más difícil será clasificar correctamente los sujetos de observación, lo que habitualmente implica valores de kappa más bajos. Por tanto, debe tenerse en cuenta el número de categorías a la hora de interpretar kappa.

=>No por mucho subclasificar concuerdas más temprano, sino más bien desacuerdas.

3. Para datos ordinales derivados de categorizar variables continuas, el valor de kappa depende fuertemente de las a menudo arbitrarias definiciones que se hacen de las categorías.

=>Hay que fijarse cómo se eligen los intervalos para cada categoría y si tiene sentido dicha elección.»

Espero que nuestro amable prescriptor de píldoras sobre medicina basada en pruebas también ataque el Bland Altmann, jugoso donde los haya para poner en duda nuestra fe en los resultados numéricos de tests diagnósticos emitidos por personas.

Y como consejo recurrente, buscad los datos y no sólo los resúmenes. Los buenos trabajos abundan en gráficas que muestran todos los resultados y eluden absolutizar las decisiones a partir de valores p, coeficientes kappa, etc. La estadística no sustituye al sentido común: tener un sueldo medio de 3000 euros puede significar que tu sueldo es de 6000 euros y el mío de 0 euros.